Espera-se que a Apple revele seu fone de ouvido de realidade mista de longa data como parte da WWDC 2023. Isso é uma surpresa para alguns, em parte porque a Apple tem elogiado a realidade aumentada desde pelo menos a WWDC 2017. Foi quando a Apple começou a estabelecer as bases. pela tecnologia utilizada nos fones de ouvido por meio de ferramentas de desenvolvimento no iPhone e iPad.

Foi quando a Apple apresentou pela primeira vez sua estrutura de realidade aumentada ARKit, que ajuda os desenvolvedores a criar experiências imersivas em iPhones e iPads.

O ARKit foi um foco tão importante para a Apple nos anos seguintes que dedicou grande parte de suas últimas palestras ao vivo para apresentar e demonstrar novos recursos de realidade aumentada. Quem poderia esquecer as poucas superfícies de madeira que serviam como superfícies para a construção de cenários virtuais de LEGO no palco?

Ao enfatizar essas ferramentas, a Apple comunicou a importância da tecnologia de realidade aumentada como parte do futuro de suas plataformas.

O software do iPhone e do iPad não é a única coisa que começou a ser projetada para um futuro de realidade mista. O hardware do iPhone e do iPad também se tornou mais equipado para servir como janelas portáteis para um mundo de realidade aumentada.

Começando com o recurso Face ID e Animoji da Apple (e mais tarde Memoji), a Apple começou a ajustar o iPhone para recursos de AR. Internamente, a Apple adaptou o Neural Engine do iPhone para lidar com a realidade aumentada sem problemas.

A câmera principal do iPhone até adicionou um sensor LiDAR dedicado, como rovers lunares que navegam na superfície da Lua e carros autônomos que lêem seus arredores.

Houve até uma atualização de hardware para o iPad Pro que se concentrou quase inteiramente na adição de um scanner LiDAR à câmera traseira.

Porque? Claro, ajudou na detecção de foco e profundidade para fotos no modo Retrato, mas também havia aplicativos iPad dedicados para decorar seu quarto com móveis virtuais ou experimentar óculos sem as molduras.

O que ficou claro desde o início é que o ARKit não se destina inteiramente a experiências imersivas via iPhone e iPad. A tela do telefone é muito pequena para ser realmente imersiva e o peso do tablet é muito pesado para suportar longos períodos de uso.

Existe um uso absoluto para AR em iPhones e iPads. Pegar monstros de bolso no mundo real é mais divertido no Pokémon GO do que em um ambiente totalmente digital. Dissecar uma criatura virtual em uma sala de aula também pode ser mais divertido do que tocar entranhas reais.

Ainda assim, as experiências mais imersivas que realmente enganam seu cérebro fazendo-o pensar que você está realmente cercado por qualquer conteúdo digital que esteja visualizando requer óculos.

Isso significa que todos se importarão o suficiente com AR e VR para tornar o fone de ouvido um sucesso? Às vezes, as reações ao AR no iPhone e no iPad são de que a Apple está oferecendo uma solução em busca de um problema.

Ainda assim, existem algumas experiências AR que são claramente deliciosas.

Quer ver todas as dimensões do iPhone ou MacBook anunciadas, mas não lançadas? AR é provavelmente como muitas pessoas experimentaram o Mac Pro e Exibição profissional XDR pela primeira vez.

Projetar um foguete espacial virtual em escala 1:1 em sua sala de estar também lhe dará uma boa ideia da escala dessas máquinas. Experimentar o lançamento de um foguete virtual que permite que você olhe para a Terra como se fosse um passageiro também pode ser emocionante.

A realidade aumentada também tem sido o melhor método de apresentar meus filhos aos dinossauros sem correr o risco de viajar no tempo e trazer o T-Rex de volta ao presente.

Quanto ao ARKit, há várias maneiras de a Apple criar ferramentas abertamente que serão usadas para o desenvolvimento da experiência com fones de ouvido a partir do próximo mês.

Para começar, a estrutura introduziu uma maneira de fornecer aos desenvolvedores as ferramentas, APIs e bibliotecas necessárias para criar aplicativos AR em primeiro lugar. Rastreamento de movimento, detecção de cena, detecção de luz e integração de câmera são todos necessários para introduzir aplicativos AR.

O rastreamento do mundo real é outro fator importante. O ARKit introduziu as ferramentas necessárias para usar sensores de hardware, como câmera, giroscópio e acelerômetro, para rastrear com precisão a posição de objetos virtuais em um ambiente real por meio de dispositivos Apple.

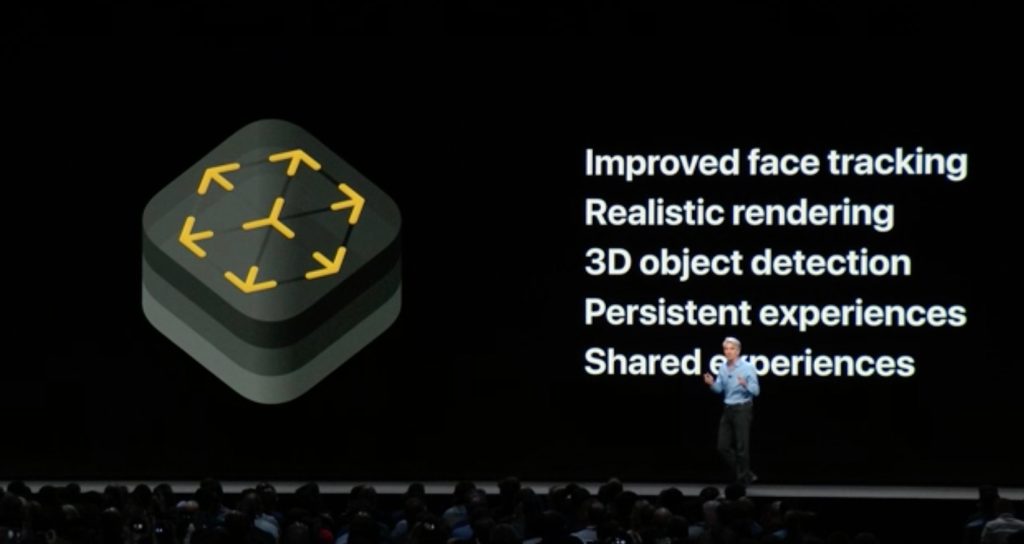

Depois, há o rastreamento de rosto. O ARKit permite que os desenvolvedores incluam os mesmos recursos de rastreamento de rosto que a Apple usa para alimentar Animoji e Memoji com espelhamento de expressão facial.

AR Quick Look é outra tecnologia mencionada acima. É isso que as experiências AR usam para colocar objetos virtuais como produtos no ambiente real ao seu redor. Dimensionar corretamente esses objetos e lembrar sua posição em relação ao seu dispositivo ajuda a criar a ilusão.

As versões mais recentes do ARKit se concentraram no suporte a experiências AR compartilhadas que podem persistir entre os usos, detectar objetos em seu ambiente e excluir pessoas de cenas. O desempenho também foi constantemente ajustado ao longo dos anos, portanto, a tecnologia principal que alimenta as experiências de VR e AR em fones de ouvido deve ser bastante sólida.

Estamos ansiosos para nossa primeira olhada oficial nos fones de ouvido da Apple na segunda-feira, 5 de junho, quando a Apple inicia seu próximo evento principal. 9to5Mac estará presente no evento especial, portanto, fique atento para uma cobertura completa e de perto. Boa sorte para ele HTC Vivo e meta fones de ouvido do mundo.

FTC: Usamos links de afiliados automáticos que geram receita. Avançar.